Destino esta semana anunciado um novo modelo de inteligência artificial (IA) aberto fonte vinculando vários tipos de dados, incluindo texto, áudio, dados visuais, leituras de temperatura e movimento. O modelo é apenas um projeto de pesquisa no momento, sem aplicações práticas ou de consumo imediatas. No entanto, aponta para um futuro de sistemas inteligência artificial generativa capaz de criar experiências imersivas e multissensorial. O nome dele é MetaImageBind e explicamos como funciona.

A Meta apresenta o ImageBind, um novo modelo de IA multissensorial de código aberto. Veja como funciona e o que pode fazer

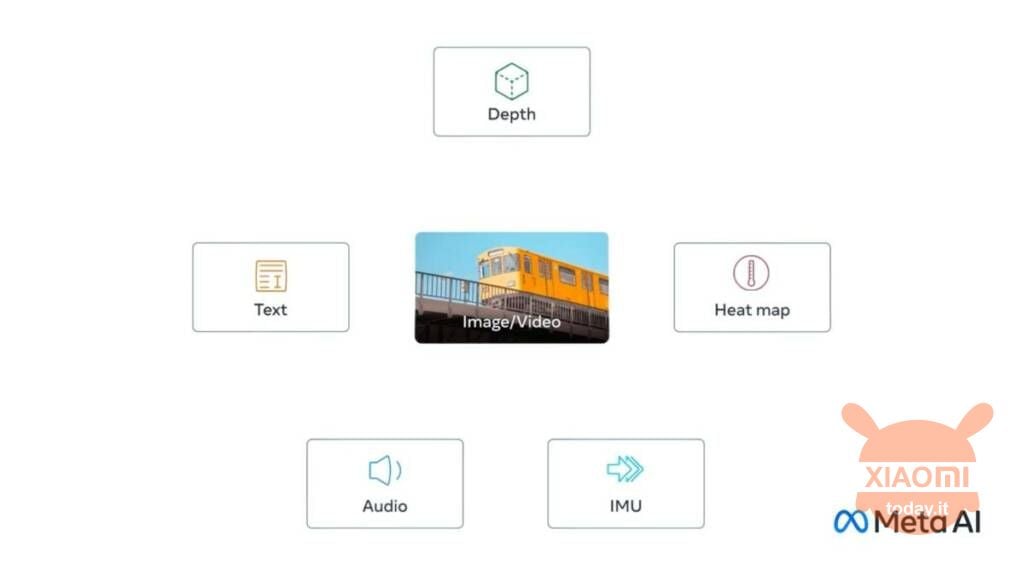

A novidade se chama Meta ImageBind e é a primeira a combinar seis tipos de dados em um único espaço multidimensional. Os seis tipos de dados incluídos no modelo são:

- Visuais (na forma de imagens e vídeos)

- Térmica (imagem infravermelha)

- Textos

- em áudio

- Informações detalhadas

- Leituras de movimento geradas por uma Unidade de Medição Inercial, ou IMU

Veja também: Meta apresenta SAM, a IA que identifica elementos individuais em imagens

A ideia é que os futuros sistemas de IA possam fazer cruzar esses dados da mesma forma que os sistemas atuais fazem para entrada de texto. Imagine, por exemplo, um dispositivo futurista de realidade virtual que gere não apenas entradas de áudio e visuais, mas também nosso ambiente e nosso movimento em um palco físico. O usuário pode solicitar que a ferramenta emular uma longa viagem marítima, e o colocaria não apenas em um navio com o barulho das ondas ao fundo, mas também o balanço do convés sob os pés e a brisa fresca do ar do oceano. A ideia é que a plataforma combine vários formatos de dados para gerar o resultado.

Em uma postagem no blog, Meta observa que outros fluxos de entrada sensorial podem ser adicionados para modelos futuros, incluindo “sinais cerebrais de toque, fala, cheiro e fMRI“. Este recurso recém-lançado ainda não está pronto, então a comunidade não pode testá-lo neste estágio inicial, mesmo que esteja em um estágio avançado de desenvolvimento.